Ugyanott tartunk, mint az iparmágnások a 19. században, csak mi tudjuk, milyen kockázatot jelent az új ipari forradalom

Utólag könnyű okosnak lenni, ahogy a mondás is tartja. Milyen jó lenne visszamenni 100-200 évet az időben, és valahogy rávenni az embereket, hogy ne égessenek szenet, földgázt és olajat úgy, mintha nem lenne holnap, mert tényleg nem lesz – de legalábbis megszűnnek a klasszikus évszakok és felforrnak az emberek.

Elvileg itt a nyakunkon következő ipari forradalom, és abban a kiváltságos helyzetben vagyunk, hogy már most látjuk, milyen káros következménye lehet az egyébként sok szempontból elképesztő potenciált jelentő mesterséges intelligenciának. A következmények nem csak pozitívak lehetnek: rengeteg diák úgy kap diplomát, hogy gyakorlatilag az MI-t küldi be maga helyett egyetemre, a gép rendszeresen hallucinál, és a Google keresője is egyre rosszabb az MI miatt.

Persze minden ipari forradalomnak ára van, de míg a 19. században az emberek nem tudták, hogy eszik-e, vagy isszák az üvegházhatású gázokat, addig mi most pontosan látjuk, hogy mekkora kárt okoz a környezetünkben az MI. Azaz egészen pontosan nem láthatjuk, de csak azért, mert eltitkolják.

Nehéz, sőt, szinte lehetetlen megállapítani, hogy mennyi energiába kerül egy válasz az MI-től, aminek több oka is van. Az egyik az, hogy modellje válogatja, így ebből a szempontból attól függ, hogy a csetbot mögött meghúzódó nagy nyelvi modell (LLM) mennyire összetett. Minél aprólékosabb, minél több paramétert tud figyelembe venni a válaszadáshoz, annál több energiára van szüksége. A másik az, hogy a legnépszerűbb MI-k nem nyílt forráskódúak, és a fejlesztő cégek nem árulják el, mi kell a futtatásukhoz – csak megígérik, hogy igyekszenek a lehető legkevésbé környezetszennyezők lenni, ami a gyakorlatban igazából semmit nem jelent. Az OpenAI néha közöl valamilyen adatokat, de június közepén is csak annyit mondtak, hogy egy átlagos kérdéshez körülbelül egytizenötöd teáskanálnyi vízre van szükség. Ezt azonban semmivel nem támasztották alá, úgyhogy a kutatók nem nagyon tudnak számolni vele.

Ez nem azt jelenti, hogy nem is érdemes megpróbálni kiszámolni, hogy mibe kerül nekünk, ha megköszönjük a ChatGPT-nek a választ, és az MIT Technology Review részletes elemzésében meg is kísérelte ezt. Persze nem hasraütésszerűen mondták be a számokat, két tucat szakemberrel egyeztettek, több különböző MI-modellt is megvizsgáltak, rengeteget jelentést összegeztek és az MI-k mögött álló cégeket is megkeresték. Az elemzést itt megtalálja, akit részletekbe menően érdekel.

Pár perc a mikróban

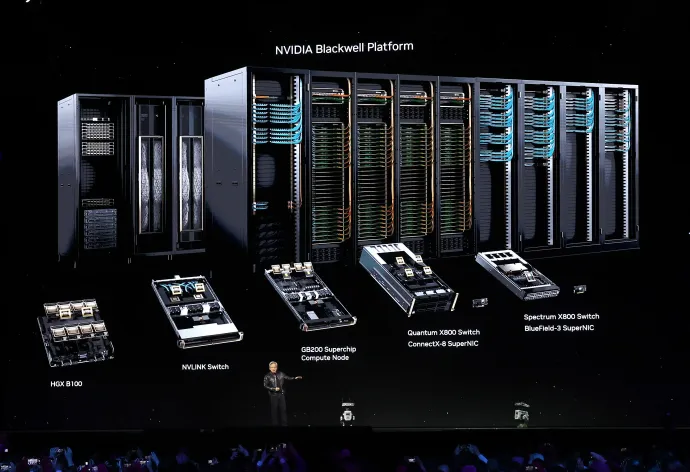

Ahhoz, hogy felmérjék az MI-ágazat energiaigényét, azzal a kérdéssel kezdtek, hogy mennyit eszik egy válaszhoz. Az MI-k adatközpontokban laknak, amik gyakorlatilag óriási raktárak tele szerverekkel és az azokat hűtő rendszerrel. Az MI-k a válaszadáshoz fejlett grafikus egységeket (videókártyákat, GPU-kat) használnak – ezért is szárnyalnak az ilyeneket gyártó Nvidia részvényei – ez veszi fel az energia nagy részét. Persze szükségük van processzorokra is, amik szintén árammal működnek, és azt sem szabad elfelejteni, hogy a hűtést sem csak a helyi szellővel oldják meg. De az adatközpontokra majd később kitérünk.

Ahhoz, hogy az MI meg tudja mondani, hogy mondjuk hány fok lesz nyáron (rosszul), először be kell tanítani, azaz meg kell etetni vele rengeteg releváns és kevésbé releváns adatot, amik alapján felfedez mintákat, és az ismereteit felhasználva válaszol. Azonban ez is egy energiaigényes folyamat: becslések szerint az OpenAI 100 millió dollárt és 50 gigawattórányi energiát használt fel a GPT-4 betanítására. Ennyi energiával San Francisco városa nagyjából három napig kényelmesen elketyegne. Az MIT Technology Review által megkérdezett szakértők szerint az igazi pénz abban van, hogy az emberek az MI-t faggatják, becslések szerint a mesterséges intelligencia számítási kapacitásának 80-90 százaléka erre megy el.

Azt, hogy egy kérés, kérdés mennyi energiába kerül, nem olyan egyszerű kiszámolni, mint mondjuk egy autó károsanyag-kibocsátását. Mint említettük, ez modell és modell között eltér, és még az is nagy szerepet játszik, hogy az adatközpont, amin az a része lakik, ahova a kérdés eljutott, milyen áramhálózatra van rácsatlakoztatva.

A legnagyobb, legismertebb modelleknél nem lehet tudni, hogy miután az ember elküldi a kérdését, mi történik, milyen költsége van. A gyártók üzleti titokra hivatkoznak, de az sem elképzelhetetlen, hogy az adatok rontanának a cégek megítélésén.

Léteznek azonban nyílt forráskódú modellek, és a kutatók ki tudnak indulni azokból. Például fel tudják mérni, nagyjából mekkora az egyik legnépszerűbb GPU, az Nvidia H100-as csipjének energiaigénye. Eddigi mérések alapján egy LLM teljes energiaköltsége nagyjából a GPU energiaköltsége kétszeresének felel meg.

A lap a Michigani Egyetem kutatói, Jae-Won Chung és Mosharaf Chowdhury segítségével a Meta nyílt forráskódú Llama modelljén tesztelték, mi mennyibe kerül. Pontosabban a Llama különböző változatain.

A 3.1 8B változatban 8 milliárd paramétert figyelembe véve jósolja meg a válaszába való következő szót a csetbot, és több különböző kérdésre adott válaszai alapján egy válasz nagyjából 57 joule energiát igényelt a H100-as csiptől, így egy válasz 114 J-t használt el. Ez nem sok, nagyjából arra elég, hogy egy mikró egy tizedmásodpercig működjön.

A legnagyobb, szöveggenerálásra használt modell a kísérletben, a Llama 3.1 405B ötvenszer ennyi paraméterrel dolgozik, így jobb választ is ad. Így interakció 3353 J-be, tehát 6706 J-be került, ami 8 másodpercnyi mikrózásra elég.

Tehát minél komplexebb a modell, annál több energiát használ – hiszen annál több csipre van szükség. A kísérlet során a legnagyobb modelleknek 405 milliárd paramétere volt, de léteznek népszerű, nagyobb modellek, mint például a 600 milliárdos DeepSeek, és a GPT-4 becslések szerint akár 1 billó (ezermilliárd) paraméteres is lehet. Persze a kérdés, azaz a prompt is számít: minél egyszerűbb, annál kevesebb energiába kerül a válasz.

Mozgóképek

A képgenerálás máshogy működik, mint a szövegalkotás, ezt diffúziónak hívják. Ezeknél maga a prompt nem is nagyon játszik szerepe az energiahasználat növekedésében, inkább az számít, hogy mekkora a modell, a kép felbontása, és az, hogy hány lépésből rakja össze a kívánt képet.

Az egyik legnépszerűbb, nyílt forráskódú képgenerátor a Stable Diffusion 3 Medium, ami 2 milliárd paraméteres, és aminek GPU-ja 1141 J-t eszik egy válaszhoz. A diffúziós modelleknél egyelőre nincs becslés arról, hogy a GPU-k mekkora részt vesznek ki a teljes működés energiahasználatából, de szakértők szerint itt is működhet az LLM-ekre ráhúzott duplázós módszer, mert még ha van is különbség, valószínűleg nem jelentős. Így a valós érték 2282 J lehet.

Ha a diffúziós lépések számát ötvenszeresükre emeljük, a képminőség nagyjából duplázódik, akárcsak az energiahasználat: 4402 J. Ez nagyjából 5,5 másodperc mikrózásra elég, tehát kevesebb energiába kerül, mint a legnagyobb szöveggenerátor használata.

A videóknál már kicsit más a helyzet. A nagy fejlesztők zárt forráskódú MI-jei egészen élethű, izgalmas videókat tudnak kiköpni magukból, de ezek energiaigénye titkolt. A nyílt forráskódú konkurencia kicsit le van maradva, de már így is egész jó videókat tudnak gyártani. A cikkhez Sasha Luccioni, a Hugging Face klímakutatója a kínai Zhipu AI nevű AI-startup CogVIdeoX modelljét tesztelte. Az energiaigényt a Code Carbon nevű szoftverrel vizsgálta.

A modell augusztusi verziója csak 8 FPS-es videókat gyártott, amik nem voltak kifejezetten jó minőségűek – inkább emlékeztettek gifekre. Ezek 109 000 J-t igényeltek. Három hónappal később azonban a cég kiadta az új verziót, ami már jó minőségű, 5 másodperces videókat is ki tudott adni magából, méghozzá másodpercenként 16 képkockánként. Ez a modell 30-szor annyi energiát használ az 5 másodperces videóihoz, mint elődje: 3,4 millió J-t, ami egy órányi mikrózásra is elég. Ebből kiindulva sejthető, hogy a sokkal fejlettebb, sokkal hosszabb videók gyártására is képes modellek ennek a sokszorosát használják fel.

A lap azt is bemutatta, hogy ez hogy is néz ki a hétköznapi életben. Hiszen sokan hétköznapi dolgokhoz komplexebb feladatokra is használnak több különböző modellt. A lap példaként azt hozta, hogy valaki jótékonysági céllal maratont akar futni. Ehhez feltesz 15 kérdést egy LLM-nek, hogy megtudja, hogy lehet a leghatékonyabban adományokat gyűjteni, majd generáltat magának egy szórólapot. Ahhoz, hogy az MI eltalálja, mit is szeretne, 10 próbálkozásra van szükség. Ezután három próbálkozásból kijön egy 5 másodperces videó, ami megy majd Instagramra, és kész is. Mindez 2,9 kilowattórányi áramot használt, ami akár 3,5 óra mikrózásra is elég lenne.

De mindez nem ilyen egyszerű

A cikk szerzői többször kiemelik, hogy ez mind csak becslés. Miután a cégek nem hajlandóak kiadni a pontos méréshez szükséges adatokat, csak tippelni lehet, hogy mondjuk a GPT 4o mennyi energiát használ. Ez persze nem azt jelenti, hogy nem lehet becsléseket felállítani, ahogy ők is tették.

Így, hogy ez megvan, bejönnek a képbe az adatközpontok. Eddig is léteztek, és a 2010-es évek elején készült becslések arról, hogy ezek mennyire energiaéhesek és környezetszennyezőek lesznek, elég vészjóslók voltak. Szerencsére ahogy fejlődött a technológia, ezek a becslések nem igazolódtak be, és 2010 és 2018 között a világ számítási kapacitása 550 százalékkal megemelkedett, miközben ennek energiaára alig emelkedett.

2018 után azonban a trend megint rossz irányba fordult: míg akkor a teljes áramhasználat 1,9 százalékáért voltak felelősek az adatközpontok, 2024-ben ez a szám már 4,4 volt. Virginiában a teljes állami áramhasználat 25 százalékáét ilyen adatközpontok felelnek. Jelenlegi becslések alapján 2028-ra az MI felelhet majd az USA áramhasználatának 6-12 százalékáért, azaz annyiért, mint az amerikai háztartások közel egynegyede összesen.

Ez így önmagában még nem feltétlenül lenne probléma. Érthető, hogy valami, amihez nagy számítási kapacitás kell, sok áramot használ, és van rá esély, hogy maga az MI segít majd olyan fejlesztések kiötlésében, felgyorsításában, ami hatékonyabbá teszi majd a saját működését.

A baj csak az, hogy nem lehet önmagában kezelni a dolgot. A Microsoft, a Google és az Amazon a világ legszárazabb részein telepít új adatközpontokat, ami így a helyi víz- és áramellátást kockáztatja. Ha ez nem lenne elég, a már működő adatközpontok jelentős részben károsabb, fosszilis energiaforrásokra támaszkodnak. A Harvard egy, még szakmai lektorálásra váró kutatása alapján az adatközpontok szénalapú áramhasználata 48 százalékkal magasabb, mint az amerikai átlag. Mivel ezek a központok 0-24 működnek, nem hagyatkozhatnak 100 százalékban például nap- vagy szélenergiára, mert azok nem feltétlenül állnak folyamatosan rendelkezésre. Az egyszerűbb megoldás a régi fosszilis erőművek újranyitása és újak telepítése, míg egy fokkal jobb az új atomerőművek építése, régiek kiaknázása, amit például a Meta is tervez.

Az sem mindegy, hogy egy adatközpont milyen áramkörön van: ha egy olyanon, ami inkább szénalapú, mint mondjuk Virginiában vagy Pennsylvaniában, akkor sokkal piszkosabb áramot használ, mint mondjuk a nap- és szélerőművekben gazdagabb Kaliforniában.

Kaliforniában például ha egy prompt egy olyan adatközpontba talál be, ami Kaliforniában van, és nappal ért be, akkor nagyjából kilowattóránként 70 gramm szén-dioxid-kibocsátásnyi fosszilis alapú energiába kerül, Azonban ha éjszaka kapja ugyanaz az adatközpont a kérést, akkor – mivel nem süt a nap – ugyanez akár 300 gramm is lehet. A maratonos-jótékonykodós példa Kaliforniában a jobbik esetben 650 gramm szén-dioxid-kibocsátással járna, az adatközpont-főváros West Virginiában ugyanez 1150 grammot termel.

A ChatGPT a világ egyik legnépszerűbb weboldala, az OpenAI decemberben azt ünnepelte, hogy napi egymilliárd kérdést kapnak. Becslések szerint ez egy év alatt ugyanannyi áramot használ, mint bő tízezer amerikai háztartás – és akkor még nem is vettük ide a többi modellt. Azt is fontos kiemelni, hogy nemcsak dedikált csetbotokban találkozhatunk MI-vel, mert a cégek a legtöbb, a mindennapi életünk részeit képező szolgáltatásba be akarják építeni. Ha akarjuk, ha nem.

Ez azokban az országokban, ahol sok adatközpont van, nemcsak azzal járhat, hogy gyorsul a globális klímaváltozás, az emberek a saját pénztárcájukon is megérezhetik. Ugyanis például az USA-ban a Metához hasonló techóriások kedvezményes áron kapják az áramot a szolgáltatóktól, aminek előfordul, hogy a hétköznapi fogyasztók isszák meg a levét. Ha egy adatközpont nem kapja meg a beígért forgalmat, vagy valamiért kevesebb áramot használ, akkor a helyi fogyasztók áramdíja emelkedik meg, hogy kipótolja az áramszolgáltató kiesését. Egy 2024-es jelentés szerint a virginiaiak átlagosan akár havi 37,5 dollárral (13 ezer forinttal) fizethetnek többet, hogy ellensúlyozzák az adatközpontok áramdíját.

„Nem egyértelmű, hogy ezeknek az adatközpontoknak az előnye nagyobb-e, mint a hátrányuk. Miért nekünk kéne fizetni ezért az infrastruktúráért? Miért kéne nekünk állni a villanyszámlájukat?”

– tette fel a kérdést Eliza Martin, a Harvard kutatója.

Bár az egyes kérdések, képgenerálások nem használnak sok energiát, de sok kicsi sokra megy. Az MI nem megy sehova, egyre inkább az életünk része lesz, ezt el kell fogadnunk. Emiatt fontos lenne, hogy a cégek transzparensek legyenek azzal kapcsolatban, hogy az adatközpontjaik mennyi áramot használnak, hogy a felhasználók is tudják, milyen ára van annak, hogy akciófiguraként vagy Ghibli-karakterként ábrázoltatják magukat. Hiába érdekes kísérlet, valószínűleg pont ezért az idei volt az utolsó, hogy leérettségiztettük a mesterséges intelligenciákat.

Viszont ugye lehet, hogy az MI magában hordozza a saját fejlesztését, megtisztítását, ami – bár egyáltalán nem biztos, és joggal tűnhet egyelőre PR-szövegnek – izgalmasan és biztatóan hangzik. Az MIT Technology Review azt is összegyűjtötte, mi ad okot optimizmusra az MI energiahasználatával kapcsolatban. Ahogy fejlődnek a modellek, jó eséllyel hatékonyabban működnek majd, hiszen a gyártó anyagi érdeke is, hogy kevesebb költsége legyen az üzemeltetéssel. Emellett a számítógépekben és szerverekben használt csipek is egyre hatékonyabbak, és hasonló várható az adatközpontoktól is. A gyártók állítják, hogy nagyban dolgoznak a még jobb léghűtéses rendszereken, hogy ne használjanak annyi vizet, de egyelőre inkább pont, hogy léghűtésről állnak át a vízhűtésre, úgyhogy ez semmiképp sem egy rövid távon bekövetkező változás.

A céges titkolózás miatt ugyan kevés konkrét adat áll a kutatók rendelkezésére, de látszik, hogy minden ChatGPT-vel generált útitervnek, receptnek és kódsornak ára van. A 19. századi iparmágnásokkal szemben mi nemcsak az emberi árát látjuk a féktelen fejlődésnek, hanem a környezeti kockázatot is. Az MI megmarad, ami sok szempontból jó, izgalmas dolog. De ettől még érdemes lehet nem a lovak közé dobni a gyeplőt.